作者丨邱晓芬

编辑丨苏建勋

7月4日-7日,世界人工智能大会(下称WAIC)在上海世博展馆开启。而算力,作为AI发展的刚需要素,让展馆中的芯片企业成为关注焦点。

如果说,去年的WAIC上,行业里GPU只有英伟达一个独苗可以选择,情况在今年有了巨大的变化。

2024年的WAIC,分为H1、H2、H3三个馆。据《智能涌现》作者观察,其中,H2馆基本有一半的厂商都是和智算中心、芯片有关的厂商,大玩家也基本聚齐:华为、百度昆仑芯、天数智芯、摩尔线程、算能、中科曙光、燧原等等。

不过,由于芯片还是一个相对敏感的话题,冒头的厂商们,展示方式上还是略显收敛。

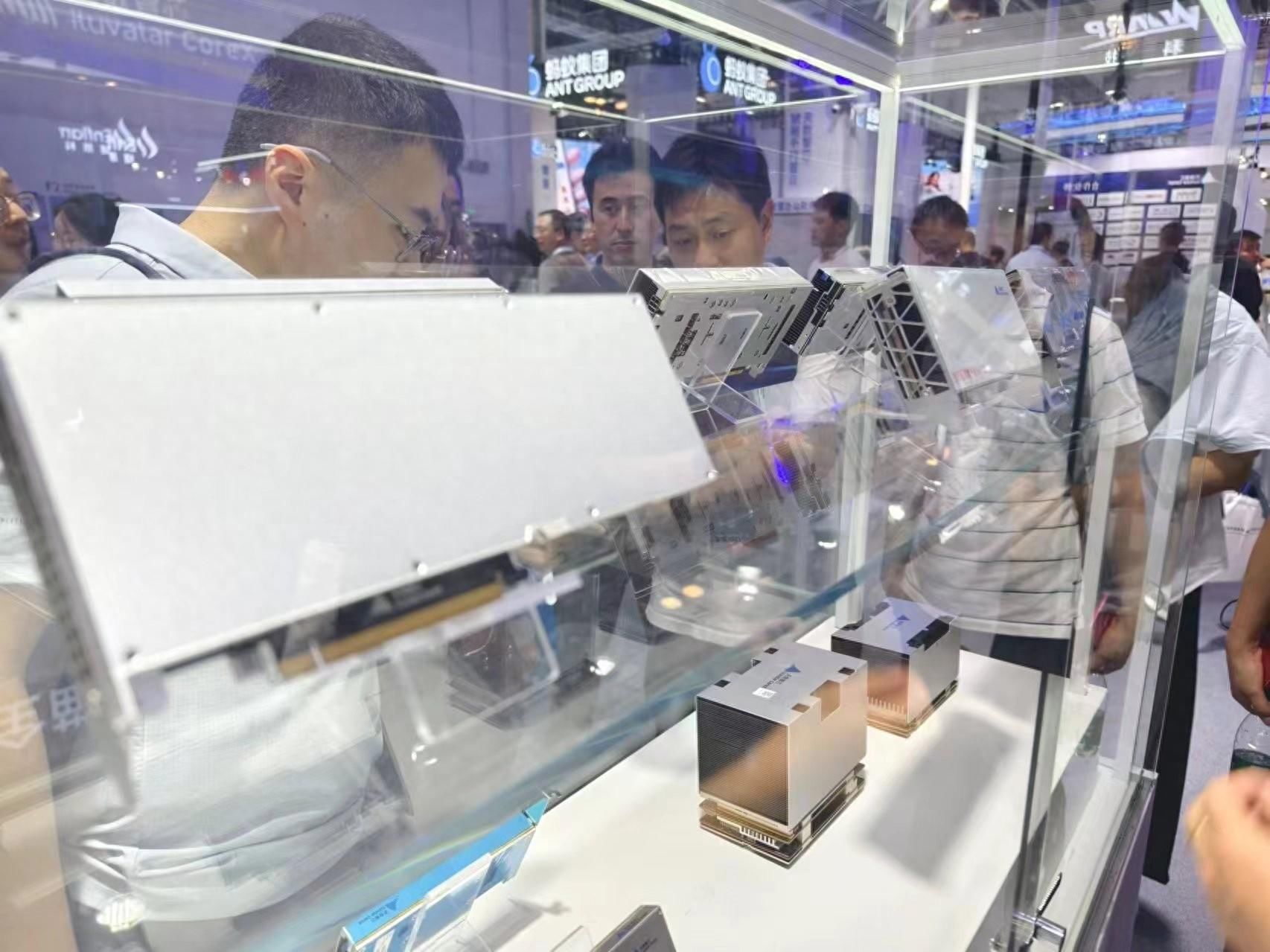

WAIC上的芯片展台挤满了人 作者拍摄

多位芯片厂商人士告诉《智能涌现》,他们最新的芯片产品并不敢拿出来展示,也不打算正式发布。在展示方式上,大家形成了心照不宣的默契,并不愿意直接呈现芯片本身——而是直接呈现装好芯片的服务器,或者是以合作伙伴的落地案例来展现。

WAIC作为人工智能行业的一个集中观察窗口,从这里我们可以窥见2024年的国产算力发展趋势。随着大模型逐渐往两派分化——一派追逐务实的商业化落地,另外一派是技术理想派,还在持续进发追求高参数量。

有趣的是,同样的趋势也出现在上游的算力端。目前,国内的芯片厂商也呈现了策略上的两极分化,一派继续往万卡、万P进发,另一派则更关注大模型在各行各业的落地诉求,推理芯片进入爆发前夜。

推理芯片大爆发在WAIC上,有多家芯片厂商称其推理芯片销售量大幅提升。比如,天数智芯、燧原的工作人员都告诉《智能涌现》,他们的推理芯片产品去年以来都有了数万片的出货,出货渠道包括智算中心等等。

百度的一位工作人员也表示,昆仑芯过去两代产品也都是推理卡,目前来自百度和外部渠道的出货量大概是1:1,“至今累计出货量也有三五万片左右”。

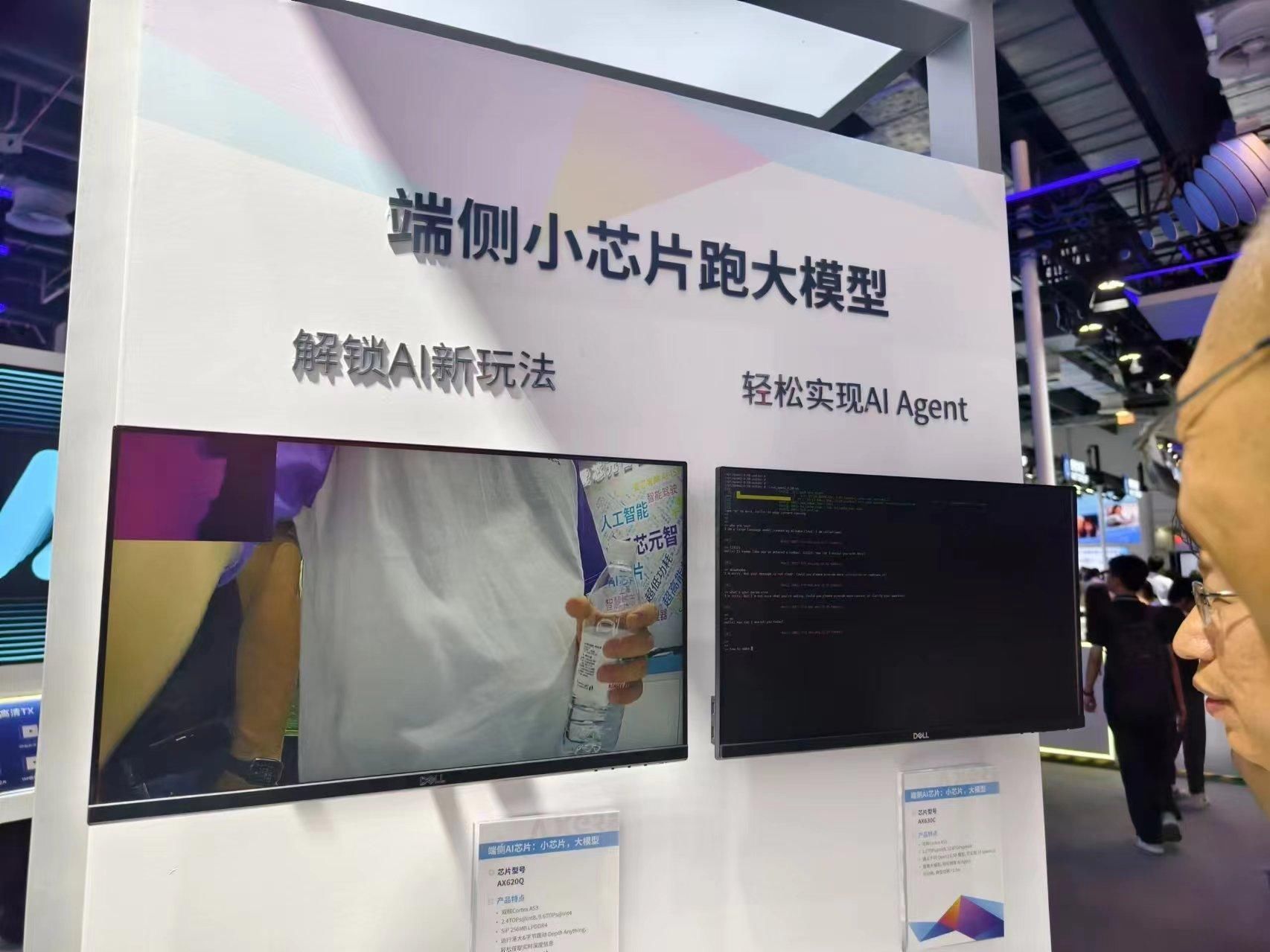

不过,前述这些芯片厂商的推理卡,还是面向更大的模型参数,主打云端,当前也有不少芯片厂商瞄准了端侧的机会,主打用一颗小芯片跑端侧大模型推理。

芯片厂商「爱芯元智」的一位工作人员告诉《智能涌现》,他们的某颗小芯片虽然只能运行2B参数量的模型,但优点是可以进行本地端侧运行,保证了隐私性,成本上也很可观。据其介绍,目前这颗芯片能广泛用于监控摄像头等IoT设备上,已是“供不应求的状态”。

端侧小芯片展台火热 作者拍摄

推理芯片的大爆发,是一个市场和竞争综合作用的结果。

随着主流大模型逐渐推进开源、以及大模型厂商们今年为了抢夺市场疯狂降价,大模型逐渐在各行各业落地。推理正是一个“用”大模型的过程,需要大量的推理芯片的支撑。和训练场景不一样的是,推理芯片面向的是各行各业,眼前是星辰大海。

而更重要的是,这也是英伟达芯片没有渗透到的广泛市场。在此前,行业内一般采用英伟达的4090、L20这些产品来跑大模型推理,不过英伟达这类产品的缺点也相当明显。

比如,英伟达的4090其实是消费级显卡,英伟达官方并不允许其运用于大模型推理,目前也面临着禁运的情况。而更关键的是,英伟达这些芯片由于并非针对推理场景制定,存在着功耗过大、内存不够等情况,难以满足诉求。

而前述那些“卖爆”的产品,也正是基于英伟达的种种阿喀琉斯之踵而切入。4090、L20,基本是这些国产推理卡的直接对标对象。

一名天数智芯的工作人员称,他们推出的“大模型推理16卡服务器”,16卡服务器的单机显存达到512GB,单卡成本和4090差不多的情况下,功耗只有其1/3,并且,“供应稳定持续有货”,目前已经打入了某大模型厂商供应链。

除了传统的芯片厂商之外,《智能涌现》发现,目前也有中兴在内的新玩家进入推理芯片市场,以及出现了全新的商业模式。

“如今已到了推理卡爆发的前夜”,一位芯片厂商人士感慨道。

从千卡跃进万卡,这是少数人的游戏一面是推理芯片爆发,另一面是,国产芯片厂商在还在坚持追逐更高的算力,国产算力集群逐渐从过去的千卡规模,向万卡规模进发。在WAIC上,摩尔线程也发布了国内首个万卡规模的智算集群解决方案“夸娥”(KUAE)。

目前,超万卡集群已经成为头部大模型厂商预训练的标配。在海外,Open AI、谷歌、Meta都已经有了万卡集群。其中,Open AI更是拥有五万卡以上的规模。

《智能涌现》了解到,目前国内只有字节跳动等极少数企业拥有万卡规模,都是英伟达的产品。另外,华为、摩尔线程也是万卡规模的拥簇者,不过都是用各自的芯片搭建而成。

万卡集群是针对万亿参数级别的大模型而设计,目前行业对此,有的持乐观态度,有的还在观望、犹豫。

在WAIC上,有不少芯片厂商人士向《智能涌现》提出了自己的顾虑——万卡智算中心的投入动辄几十亿,而万亿参数的大模型目前应用场景有限,商业落地的可行性还要再继续考察。这些厂商目前更关注几百卡、几千卡的集群规模优化。

另外,从千卡到万卡级别,不仅仅是GPU数量多个零那么简单,而是在软件层面提出了更高的要求。

接踵而来的难题是:万卡集群如何搭建超大规模的组网互联系统?一万张GPU的计算效率如何最大化?大模型训练时如何保证高稳定性和长期稳定性?万卡集群不仅仅是硬件投入翻十倍那么简单,还有更多软件上的功夫要做。

不过,坚定的万卡集群拥簇者们,则对于这一切持乐观态度。

摩尔线程创始人张建中表示,一方面,自从2020年提出的大模型Scaling Law在未来将会持续奏效——通过算力、算法、数据的深度融合与经验积累,实现模型性能的飞跃,这种“暴力美学”将继续影响未来大模型的趋势。

另一方面,Transformer架构虽然是当前主流,但新兴架构(如Mamba、RWKV、RetNet)还在不断刷新计算效率。架构的创新,都会转化为对更高性能计算资源的需求。

目前,万卡集群毕竟还是少数人的游戏,背后考验的是,芯片厂商们的金钱实力、技术能力、商业判断等等。

end

end

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com